SEO Analyzer Pro: Analiza de forma gráfica datos de Screaming Frog

Si llevas tiempo haciendo SEO, seguro que has vivido esto: terminas un crawl de Screaming Frog de un sitio con 450.000 URLs, exportas los datos, abres el Excel y… te quedas mirando la pantalla. Porque sí, tienes toda la información del mundo ahí delante. Pero convertir esas 93 columnas en algo que puedas usar de verdad es otro cantar.

Screaming Frog es, sin duda, una de las herramientas más potentes para auditorías técnicas. El problema no es la herramienta. El problema es que te exporta tantísima información que luego pasas horas (literalmente, horas) montando tablas dinámicas, buscando duplicados con fórmulas raras y creando gráficos que medio funcionan. Y al final del día, tienes un Excel con 15 pestañas que solo tú entiendes.

En SEOStar llevamos años haciendo esto. Auditorías técnicas, migraciones, troubleshooting de caídas de tráfico. Y después de pelearme con Excel más veces de las que me gustaría admitir, pensé: tiene que haber una forma mejor de hacer esto. Así que construimos SEO Analyzer Pro. Y sí, la hemos dejado gratis porque, bueno, la comunidad SEO nos ha dado mucho y nos pareció justo devolver algo.

¿Qué es exactamente esta herramienta?

SEO Analyzer Pro no va a hacer el crawl por ti. Eso sigue siendo cosa de Screaming Frog. Lo que hace es lo siguiente: coges el XLSX que exportas, lo subes, y la herramienta te da un dashboard completo con todo analizado, clasificado y priorizado.

Básicamente, automatiza la parte más tediosa del trabajo:

- Detecta títulos duplicados o que no cumplen con las longitudes recomendadas

- Identifica meta descriptions problemáticas

- Revisa tu estructura de H1 y H2

- Clasifica los códigos de respuesta HTTP

- Analiza la distribución del contenido según word count

- Evalúa la profundidad de crawl y la arquitectura de información

Todo esto lo hace en tu navegador. Los datos no se van a ningún servidor, se procesan localmente. Cero riesgos de confidencialidad, que cuando trabajas con clientes bajo NDA es algo que importa bastante.

El workflow que todos conocemos (y que cansa)

Déjame describir el proceso habitual:

Haces un crawl completo. Pongamos que son 400.000 URLs internas. Exportas a Excel. Abres el archivo. Y empiezas. Filtras por aquí, creas una tabla dinámica por allá, sumas con fórmulas que copias de Stack Overflow porque nunca te acuerdas de la sintaxis exacta. Haces algunos gráficos para que quede bonito en el informe.

Tres horas después (si vas rápido), tienes algo presentable. Pero sabes que si otro compañero de equipo hace el mismo análisis, probablemente llegue a conclusiones ligeramente distintas. Porque el proceso es manual, hay criterio personal de por medio, y es difícil mantener consistencia.

SEO Analyzer Pro elimina esa variabilidad. Automatiza los pasos 3, 4 y 5 del proceso. El análisis es siempre el mismo. Los criterios de clasificación son consistentes. Y lo que antes te llevaba horas, ahora son 45 segundos.

Cómo funciona el análisis (sin magia, solo código)

Exportas desde Screaming Frog

Nada nuevo aquí. Haces tu crawl normal, aplicas el filtro «HTML» en la vista «Internal», exportas a XLSX. El formato estándar de Screaming Frog funciona directamente sin que tengas que tocar nada.

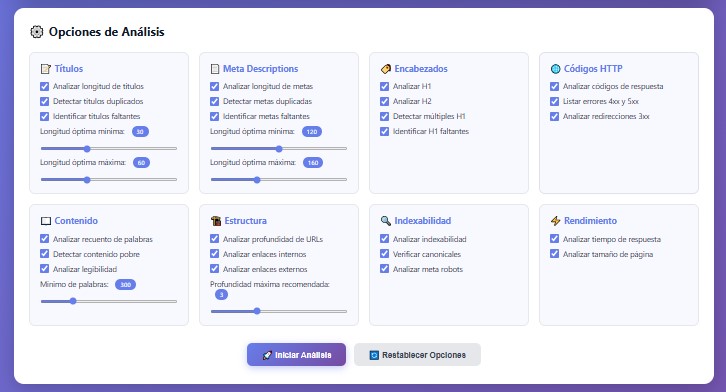

Configuras los parámetros (esto es importante)

Aquí viene una parte que muchas herramientas de análisis no ofrecen: personalización real. Porque no todos los sitios son iguales. Un e-commerce no se mide igual que un blog editorial. Una web corporativa tiene requisitos distintos a una plataforma SaaS.

Puedes ajustar:

Para títulos:

Longitud mínima y máxima que consideras óptima. Por defecto usamos 30-60 caracteres, pero si tu cliente tiene muchas landing pages con marca al final del título, quizá prefieras 35-70. Tú decides.

Para meta descriptions:

El rango estándar es 120-160 caracteres. Pero Google puede mostrar hasta ~920px en desktop. Algunos prefieren ser más generosos. La herramienta se adapta.

Para contenido:

¿Qué consideras thin content? Hay quien dice menos de 300 palabras. Nosotros usamos 100 como umbral mínimo porque en e-commerce las fichas de producto pueden ser cortas pero valiosas si están bien optimizadas. Ajusta según tu caso.

Para arquitectura:

Profundidad máxima recomendada. El estándar SEO dice «máximo 3 clics desde home», pero si auditas un medio de comunicación con años de archivo, quizá tengas que ser más flexible.

Esta configuración es clave. Define cómo se clasifica todo. Y hace que los análisis sean comparables entre sí si mantienes los mismos parámetros.

El procesamiento (aquí pasan cosas interesantes)

Una vez que cargas el archivo y configuras, el sistema hace esto:

- Parse del XLSX usando SheetJS (una librería que lee archivos Excel en JavaScript)

- Clasificación automática de cada URL según los criterios que definiste

- Detección de patrones – aquí busca duplicados, elementos missing, anomalías en la distribución

- Cálculo de métricas agregadas (promedios, porcentajes, distribuciones)

- Generación de gráficos con Chart.js

- Priorización algorítmica de issues basada en impacto potencial

Todo esto pasa en tu navegador. No hay backend. El archivo nunca sale de tu máquina. Y toma entre 5 y 15 segundos dependiendo del tamaño del dataset y de si tu ordenador es de este siglo o del anterior.

Qué análisis concretos obtienes (y por qué importan)

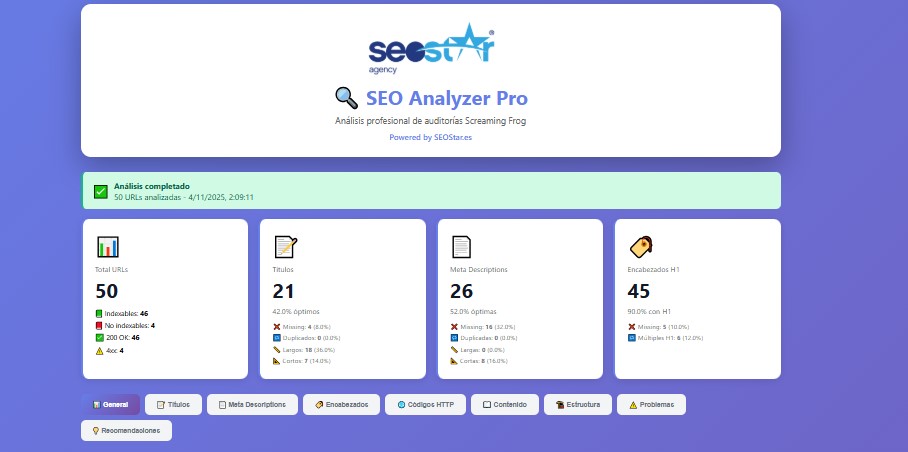

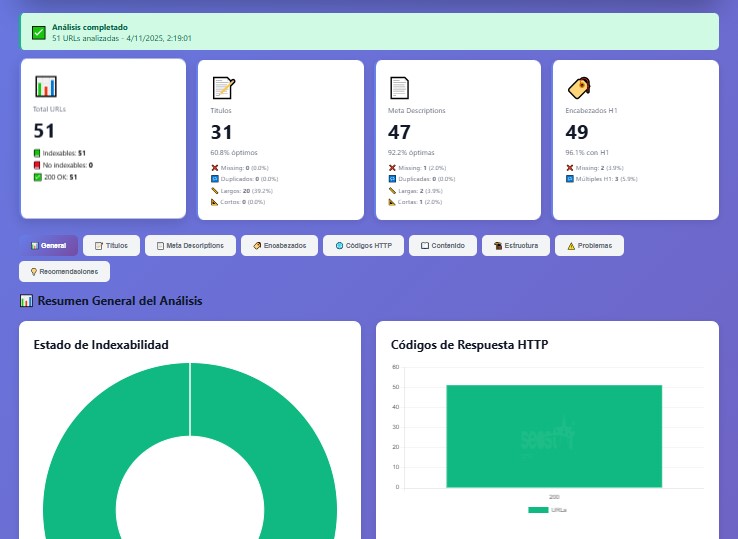

1. Vista general: el estado de salud global

Antes de entrar en detalle, la herramienta te da un overview rápido. Es esa vista que necesitas cuando tu jefe te pregunta «¿y cómo está el sitio?» y tienes 30 segundos para contestar.

Ves de golpe:

- Ratio de URLs indexables vs. bloqueadas

- Distribución de status codes (con drilldown si quieres ver URLs específicas)

- Health score de elementos on-page principales

- Distribución del contenido por word count

- Análisis de arquitectura (crawl depth)

- Los top issues más frecuentes

Es como hacerte una analítica de sangre. Te da los valores principales y ya ves si hay algo que chirría.

2. Análisis de title tags (más crítico de lo que parece)

Los titles son probablemente el factor on-page más importante que controlas directamente. La herramienta los analiza así:

Distribución por longitud:

Clasifica en cortos (menos de 30 caracteres, que es poco para trabajar keywords), óptimos (ese rango de 30-60 que todos conocemos), largos (más de 60, que Google truncará) y missing (páginas sin título, que es un drama).

Detección de duplicados:

Encuentra títulos exactamente iguales en múltiples URLs. Esto es problemático porque genera canibalización en SERPs. Si dos páginas tienen el mismo título, Google tiene que elegir cuál mostrar, y rara vez elige la que tú querrías.

URLs sin título:

Estas son críticas. Una página sin title aparecerá en resultados con un título generado automáticamente por Google, generalmente algo poco útil como «Untitled Page» o el nombre del dominio.

Además, la herramienta considera (aunque trabaja en caracteres) que Google trunca alrededor de 600px. En la práctica, un título de 60 caracteres suele estar bien, pero si usas muchas «W» o «M» (letras anchas), puede truncarse antes.

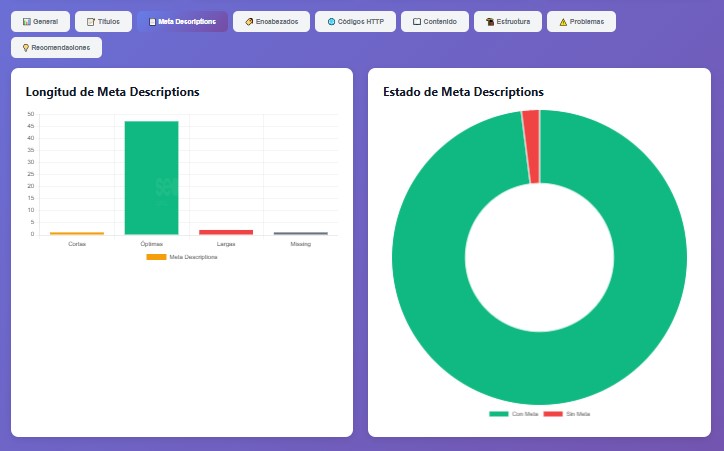

3. Meta descriptions (el eterno debate)

Vale, sí, Google no usa las meta descriptions como factor de ranking directo. Esto está confirmado desde hace años. Pero afectan al CTR, y un mejor CTR sí que mejora indirectamente tu posicionamiento. Además, aunque Google las reescribe a menudo, cuando decides mantener tu description, suele ser porque es relevante para la query. Así que vale la pena optimizarlas.

El análisis cubre:

Longitud:

Cortas (menos de 120 caracteres, estás desaprovechando espacio), óptimas (120-160, el sweet spot), largas (más de 160, se truncarán) y missing.

Duplicados:

Descriptions idénticas en múltiples páginas. Pierdes la oportunidad de diferenciar tu contenido en las SERPs. Cada página debería vender su propuesta de valor única.

Missing:

Cuando no hay description, Google saca un snippet del contenido de la página. A veces funciona bien, a veces saca la peor frase posible. Mejor controlarlo tú.

Una nota técnica: Google puede mostrar hasta ~920px de description en desktop y menos en mobile. El rango de 120-160 caracteres es conservador y funciona bien en ambos formatos.

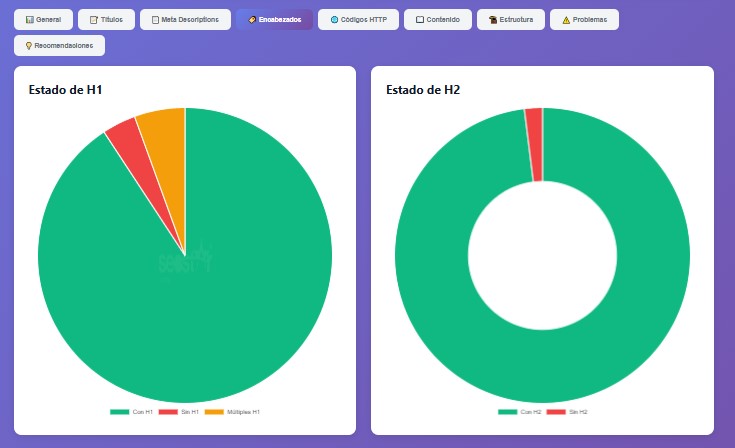

4. Estructura de heading tags (jerarquía que importa)

Los encabezados no son solo estética. Estructuran el contenido semánticamente, ayudan a la accesibilidad y a los crawlers a entender de qué va cada sección.

H1 tags:

La herramienta identifica páginas sin H1 (problema serio de estructura), páginas con múltiples H1 (puede ser válido con HTML5 semántico, pero casi siempre es un error de implementación) y analiza la distribución de longitudes.

H2 tags:

Revisa presencia o ausencia de H2s. También detecta jerarquías raras (como un H2 sin que haya H1 antes, que técnicamente funciona pero es mala práctica).

¿Por qué importa todo esto? Los H1 señalan el topic principal de cada página. Si no tienes H1, o tienes varios, confundes a los crawlers sobre cuál es el tema central. Además, los lectores de pantalla usan esta estructura para navegar, así que afecta también a accesibilidad (que es un factor de ranking indirecto).

5. Códigos de respuesta HTTP (lo que el servidor le dice al crawler)

Esta parte es crítica para entender cómo Googlebot ve tu sitio:

2xx (Success):

Todo ok. La página responde y es crawleable.

3xx (Redirects):

Aquí hay matices. Un 301 (redirect permanente) está bien si es intencional (consolidación de URLs, migración). Pero hay que vigilar las cadenas de redirecciones (A → B → C), que ralentizan el crawl y diluyen autoridad. Un 302 (redirect temporal) puede ser problemático si en realidad debería ser 301, porque Google no transfiere tanta autoridad.

4xx (Client Errors):

Un 404 significa que el contenido no existe. Si son pocas URLs antiguas, no pasa nada. Si tienes cientos de 404s de páginas que antes rankeaban, necesitas decidir: ¿las recuperas? ¿las redireccionas a contenido relevante? ¿las marcas como 410 (Gone) para que Google pare de intentar crawlearlas?

Un 403 (Forbidden) suele indicar problema de configuración del servidor o protección excesiva.

5xx (Server Errors):

Estos son críticos. Un 500 o 503 bloquea el crawl. Si Googlebot se encuentra con muchos 5xx, puede reducir tu crawl budget o temporalmente deindexar contenido.

La herramienta te da todo esto en una tabla filtrable. Puedes exportarla directamente y mandársela a desarrollo para que corrijan.

6. Análisis de contenido (thin content es tu enemigo)

Google odia el contenido delgado. Nosotros también deberíamos. Pero ¿cómo saber qué páginas son flojitas sin revisarlas una por una? Aquí entra la herramienta.

Clasifica por word count:

- Thin content (<100 palabras): Probablemente insuficiente

- Contenido medio (100-499 palabras): Depende del tipo de página

- Contenido rico (≥500 palabras): Generalmente bien

Además calcula el promedio del sitio. Si tu promedio es 150 palabras, probablemente tengas un problema sistémico de thin content. Si es 800, vas bien.

Ojo: estos umbrales no son dogma. Una ficha de producto en e-commerce con 250 palabras pero bien optimizada (especificaciones técnicas, descripciones ricas en keywords) puede funcionar perfectamente. Usa el criterio según el contexto.

7. Arquitectura y crawl depth (el link juice fluye hacia abajo)

Cada clic desde la home diluye la autoridad. Es como un río: cuanto más lejos de la fuente, menos caudal llega. Por eso las páginas importantes deberían estar cerca de la superficie.

La herramienta te muestra:

- Distribución de URLs por nivel de profundidad

- Crawl depth promedio

- Listado de URLs a más de 3 clics (o el umbral que configures)

- Análisis de internal linking (promedio de enlaces internos por página)

Si tienes contenido importante enterrado a 5-6 clics, Googlebot va a tener problemas para llegar ahí regularmente. Y aunque llegue, le estás diciendo implícitamente que no es tan importante.

8. Lista consolidada de problemas (tu to-do list técnica)

Aquí es donde la herramienta realmente brilla. Toma todos los issues detectados y los presenta en una tabla que puedes filtrar por:

- Tipo de problema (títulos, metas, H1, status codes, etc.)

- Severidad (crítico, importante, menor)

- Búsqueda de patrones en URLs

Es especialmente útil cuando necesitas priorizar. Si solo tienes tiempo para arreglar 3 cosas esta semana, empiezas por los críticos. Si estás planificando un sprint de optimización, puedes estimar esfuerzo según cuántas URLs afecta cada problema.

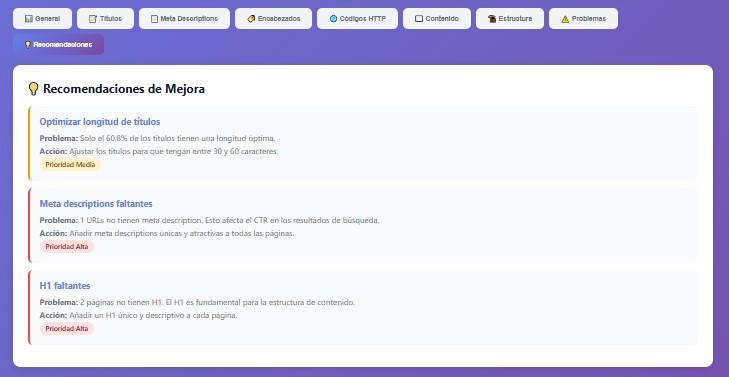

9. Recomendaciones priorizadas (qué hacer y cuándo)

La herramienta no solo te dice qué está mal. Te dice qué hacer al respecto y en qué orden.

Alta prioridad (arréglalo esta semana):

- Errores 4xx/5xx en páginas con tráfico

- Missing titles o H1s

- Cadenas de redirecciones que afectan el crawl

- Content duplicado en URLs indexables

Media prioridad (siguiente sprint):

- Títulos o metas duplicados

- Thin content en páginas indexables

- Arquitectura con profundidad > 4 niveles

- Problemas de jerarquía en headings

Baja prioridad (cuando tengas hueco):

- Optimización fina de longitudes

- Mejoras incrementales en internal linking

- Enriquecimiento de contenido medio

Cada recomendación explica el contexto, el impacto estimado y la acción concreta. Es como tener un checklist de auditoría generado automáticamente.

Por qué procesamos todo client-side (y por qué importa)

Hay herramientas que te piden subir tu archivo a su servidor. Nosotros no. Todo pasa en tu navegador. ¿Por qué?

Privacidad total:

Si auditas un cliente bajo NDA, sus datos no pueden salir de tu organización. Con procesamiento local, nunca lo hacen. El archivo se queda en tu máquina, se procesa en tu navegador, y ya está.

Compliance con GDPR:

No hay transferencia de datos personales a terceros. No hay almacenamiento en servidores externos. No hay nada que reportar en tu registro de tratamientos.

Sin riesgo de brechas:

Si no hay servidor, no hay base de datos que pueda ser hackeada. Así de simple.

Además, el procesamiento local es rápido. Muy rápido. Para un sitio de 5.000 URLs:

- Parsing del XLSX: 2-5 segundos

- Análisis y clasificación: 3-8 segundos

- Generación de gráficos: 1-2 segundos

Total: menos de 15 segundos. Y la única limitación es tu RAM disponible.

Casos de uso reales (donde esto te saca de un apuro)

Pre-migración: baseline para no cagarla

Antes de migrar un sitio (cambio de dominio, nuevo CMS, reestructuración), necesitas un baseline sólido del estado actual. Haces crawl, procesas con la herramienta, exportas el JSON completo.

Después de la migración, vuelves a hacer crawl y análisis. Comparas ambos JSONs y ves exactamente qué cambió:

- ¿Aumentaron los 404s? ¿Dónde?

- ¿Hay nuevos problemas de duplicados?

- ¿La profundidad empeoró?

- ¿Se perdieron títulos o metas?

Sin este baseline, estás volando a ciegas. Con él, puedes actuar rápido si algo va mal.

Monitoring técnico: alertas tempranas

Establece un proceso de crawl mensual. Primer lunes del mes, crawl + análisis. Compara con el mes anterior:

- ¿Subieron los errores 404?

- ¿Apareció contenido duplicado?

- ¿Empeoró el thin content?

Detectar problemas técnicos antes de que afecten el tráfico es oro puro. Y esta herramienta hace que el monitoring sea trivial.

Onboarding de clientes: impresiona desde el minuto uno

Cuando estás en la reunión de discovery con un cliente nuevo, haces esto:

- Crawl rápido del sitio en vivo

- Procesas con la herramienta mientras hablas

- Proyectas el dashboard en pantalla

- Vas mostrando los findings en tiempo real

El impacto es bestial. En lugar de decir «luego os mando el informe», estás mostrando problemas reales ahí mismo, con datos visuales. Cierra ventas.

Troubleshooting: cuando el tráfico se cae

Tienes un cliente que perdió el 30% del tráfico orgánico el mes pasado. Necesitas encontrar qué pasó.

Idealmente tienes un crawl de hace dos meses (antes de la caída). Haces crawl actual. Procesas ambos. Comparas:

- ¿Nuevos errores 5xx?

- ¿Cambios masivos en titles o metas?

- ¿Apareció thin content donde antes había contenido rico?

- ¿Se modificó la arquitectura?

Correlacionas los cambios técnicos con la fecha de caída. Y ahí suele estar la respuesta.

Integración con el resto de tu stack

Esta herramienta no vive aislada. Combínala con:

Google Search Console:

Cruza las URLs con thin content vs. sus impresiones y clics. Prioriza optimizar las que tienen potencial pero bajo rendimiento. O identifica páginas indexadas que tienen problemas técnicos graves.

Google Analytics:

Correlaciona URLs problemáticas con comportamiento del usuario. Si una página tiene thin content Y bounce rate del 85%, es candidata clara a optimización o noindex.

Herramientas de log analysis:

Si tienes acceso a logs del servidor, cruza con el análisis. Identifica URLs que Googlebot intenta crawlear frecuentemente pero que tienen problemas técnicos. Optimiza el crawl budget corrigiendo esos errores primero.

Lo que esta herramienta NO hace (seamos claros)

No ejecuta crawls.

Necesitas Screaming Frog, Sitebulb, o el crawler que uses. Esta herramienta solo analiza los datos que ya exportaste.

No analiza off-page.

Nada de backlinks, autoridad de dominio o link juice externo. Solo on-page y técnico.

No evalúa calidad del contenido.

Cuenta palabras, pero no te dice si el contenido es bueno o malo. Eso sigue siendo trabajo humano.

No se conecta a APIs.

No se integra con GSC, GA, ni nada externo. Es standalone por diseño.

Empieza a usarla (sin compromisos)

La herramienta está aquí: guposeostar.com/seo-analyzer

No hay registro. No hay límites artificiales. No hay upsells ocultos. Solo subes tu XLSX y obtienes el análisis.

Pruébala con tu próximo crawl. Si te ahorra aunque sea una hora de trabajo manual, ya habrá valido la pena.

Quiénes somos y por qué hicimos esto

En SEOStar somos una agencia enfocada en SEO técnico. No vendemos paquetes básicos ni promesas imposibles. Trabajamos con e-commerce medianos y grandes, SaaS y sitios editoriales que necesitan auditorías profundas y optimización seria.

Construimos SEO Analyzer Pro porque, francamente, la necesitábamos nosotros. Hacer auditorías era lento. El proceso de análisis de datos era tedioso. Y cada auditor tenía su propio sistema, lo que generaba inconsistencias.

Así que automatizamos lo automatizable. Y cuando la herramienta estuvo lista y funcionando, nos pareció egoísta no compartirla.

La comunidad SEO ha generado toneladas de recursos gratuitos que todos usamos. Tutoriales, scripts, herramientas. Nos pareció justo devolver algo.

Si necesitas más que una herramienta:

- Auditorías técnicas exhaustivas (más de 100 checkpoints)

- Optimización de crawl budget para sitios grandes

- Implementación de structured data

- Core Web Vitals y performance optimization

- International SEO (hreflang, arquitectura multiidioma)

- Recuperación post-penalización o post-migración

Escríbenos: info@seostar.es | www.seostar.es

Equipo SEO de Seostar

Dejar un comentario

¿Quieres unirte a la conversación?Siéntete libre de contribuir!